Data Patch

Data Patch est un projet de logiciel libre, décentralisé et indépendant pour publier des données, les éditer, les valoriser, et les co-produire avec une communauté

Description : Data Patch est un logiciel open source en cours de développement proposant une solution indépendante et libre au problème de partage de données et de contribution ouverte.

Notes :

- Pour une lecture hors ligne la plaquette synthétique (réalisé pour Numérique en commun 2021) est téléchargeable au format pdf ici => Fichier:NEC plaquette DataPatch 2021 .pdf

- Pour une lecture hors ligne le dossier complet est téléchargeable au format pdf ici => Fichier:DATA PATCH - dossier ADEME - v2.0.pdf

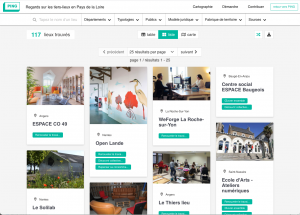

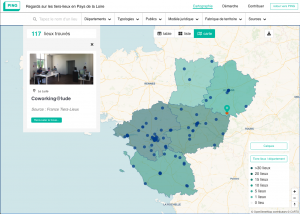

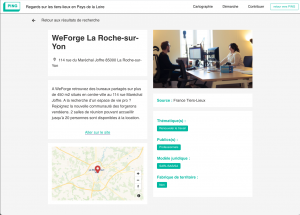

Ce projet est né d'une expérience collective, celle du recensement des lieux d'inclusion numériques par les hubs numériques régionaux (CONUMM, Rhinocc, Ternum) et des tiers-lieux (PiNG). Ces recensements visent principalement à valoriser ces bases de données ouvertes (cartographies interactives) afin que tous les opérateurs sur le territoire puissent orienter les publics et mieux diffuser l'information sur ces structures.

Au cours de ces projets - qui sont menés depuis plus d'un an - il est devenu clair qu'il y avait un besoin fondamental de faciliter la mise à jour de ces données par chaque communauté. Les communautés sont bien les premières à savoir comment elles sont composées et doivent pouvoir faire remonter cette information. En analysant collectivement ce besoin nous sommes arrivés à la conclusion qu'y répondre nécessitait des moyens dédiés, car l'offre actuelle en outils libres n'était pas satisfaisante.

La complexité technique, la simplicité d'utilisation, et le coût de la mise en place de systèmes de gestion de bases de données sont souvent sous-estimés, surtout lorsqu'on souhaite de la contribution ouverte. Il était nécessaire de monter un projet avec un périmètre précis de fonctionnalités et de cas d'usages, où le design est une composante centrale pour permettre que le grand public soit en mesure de contribuer.

Les référents en charge de ces recensements locaux sont des structures, souvent associatives, avec peu de personnels dédiés à la question des données, et chargées de faire le lien entre une communauté et un projet de partage de connaissances communes. Nous voulons souligner ici que chacune de ces communautés et chacun de ses membres possède une somme diffuse de connaissances, connaissances qu'il faut alors transformer en une base de données commune accessible à tous. Chacun des membres de la communauté doit pouvoir à la fois accéder aux données mais surtout pouvoir y contribuer simplement. La base de données devient alors un véritable commun numérique, géré et abondé collectivement.

Notre projet a pour périmètre d'expérimentation immédiat des territoires et des acteurs identifiés, lesquels sont liés par une problématique "métier" commune : l'inclusion numérique au sens large. Le besoin au coeur du projet se pose ainsi : mieux partager/valoriser des données, faciliter leur mise à jour, et permettre une modération des contributions libres. Notre projet vise à répondre à ce besoin en partant d'un cas "métier" précis, mais en réalisant une solution générique qui saura s'adapter à d'autres cas "métier". Le besoin identifié se généralise de la manière suivante :

- Comment garder la maîtrise de ses données, savoir où elles se trouvent, qui y a accès, gérer les droits ?

- Comment permettre à chacun de partager des données d'intérêt général, qu'elles puissent être facilement compréhensibles par les citoyens mais aussi interopérables avec d'autres services numériques ?

- Comment faire un outil d'open data grand public, que le design soit pensé de telle sorte que tout citoyen puisse contribuer sans pour autant être polytechnicien ?

- Comment améliorer des jeux de données en simplifiant la contribution de chacun, sans capter les informations personnelles ?

- Comment éviter la trop forte centralisation des plateformes de partage de données, privées ou publiques (Google, Airtable, Open Data Soft, data.gouv.fr...), tout en garantissant l'interopérabilité des données et la possibilité de republication?

En tant que projet de logiciel libre l'ensemble du code source est librement réutilisable, et la documentation (installation, tutoriels) permettra de simplifier sa réappropriation. De plus toutes les données hébergées sur les différentes instances du logiciel pourront être ouvertes par les utilisateurs à plusieurs niveaux (ouvrir en lecture, en collaboration, en modification directe...) en s'adossant à des licences libres pour les bases de données.

Description

Vision du projet et définition considérée de la résilience

Le cas typique est celui d'une structure comme un hub territorial (collectivité, association, entreprise, citoyen) qui créée un jeu de données thématique, et qui souhaiterait mobiliser sa communauté pour l'améliorer. Par exemple il pourrait s'agir de données recensant des lieux d'accompagnement sur un territoire, des produits dangereux, des références bibliographiques, des résultats électoraux, des lieux de reconditionnement de matériel informatique, des parcelles inoccupées, des plans de matériels DIY...

Data Patch a pour ambition de permettre à chacun d'éditer et de publier des jeux de données, que ce soit pour un usage particulier, public ou citoyen. Cela suppose que :

- des internautes puissent proposer librement des améliorations (corrections, ajouts, suppressions) à des données ouvertes par des producteurs de données ;

- les producteurs de données puissent modérer ces propositions (accepter, corriger, refuser) tout en gardant la main sur l'hébergement et la gouvernance de leurs données (gestion des droits en lecture / écriture).

- les données publiées puissent circuler et être valorisées, partagées, avec des services autres, par exemple des cartographies ou des listings interactifs.

Cette capacité à permettre la production de connaissances communes par plus grand nombre nous semble participer à une meilleure résilience territoriale. Notre définition de la résilience et son lien avec les outils numériques est détaillé plus bas (cf. §2), mais nous la résumerons comme une capacité à produire, échanger, et valoriser des informations, et de pouvoir le faire en incluant les acteurs territoriaux de toutes tailles. Ainsi le projet vise :

- Une meilleure maîtrise de l'open data territorial : alléger la dépendance à des outils et des infrastructures propriétaires, fermés, et opaques ; maîtriser l'outil de publication de données publiques ; gérer les droits des utilisateurs en lecture / écriture / contribution...

- Une mise à jour des données collaborative et modérée : simplifier le parcours de contribution / modération sur des jeux de données ; rendre intuitif le parcours de contribution (sans inscription), avec un parcours de deux clics pour modérer les contributions par le ou les administrateurs du jeu de données.

- Une mise en valeur des citoyens contributeurs : la contribution des communautés, au-delà de l'aspect purement technique/data, sera mise en valeur que ce soit graphiquement (heatmap des contributions, historique des versions) ou par un système de communication (envoi d'emails de remerciements et de commentaires entre producteurs/modérateurs et contributeurs).

- Une meilleure intelligibilité de l'open data : la comptabilité avec des outils de valorisation de données type cartographies interactives (Apiviz, GoGoCarto, OSM), data-visualisation...

Pour tenir cette promesse d'une meilleure participation des communautés il nous semble essentiel de proposer un outil techniquement performant, mais surtout dont le design est pensé pour pouvoir rendre l'outil utilisable par le grand public. Les publics composant nos communautés potentiellement contributrices sont très divers (associations, élus, citoyens...). Un effort conséquent doit être porté sur l'UX et l'UI afin que les interfaces ne soient pas une barrière à l'entrée pour ces publics mêmes, non spécialistes mais qui possèdent un savoir unique sur leur territoire.

Fonctionnalités

Les fonctionnalités de base de Data Patch sont multiples afin de rendre son utilisation la plus simple et ouverte possible :

- Identification sécurisée oauth2, validation du compte par email, récupération de son mot de passe par email ;

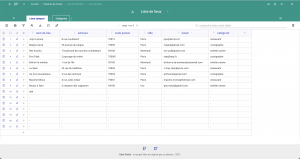

- Import et export de jeux de données sous divers formats (csv, xls, gsheet, github...) ;

- Système de notifications à la fois par mail et dans le back office permet aux modérateurs de valider ou non les propositions, le tout en un parcours de deux clics ;

- Travail sur l'UX, drag & drop des objets manipulables (espace de travail, jeux de données, lignes, colonnes...) pour un usage intuitif ;

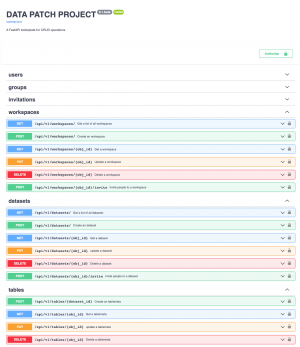

- API requêtable par des sites tiers (CORS) et sécurisée pour des usages et une valorisation sur des services tiers ;

- Multilingue, pour un usage au-delà des frontières de l'hexagone ou s'adresser à des publics étrangers résidant en France mais non francophones (migrants, réfugiés...) ;

- Publication sur des services tiers ;

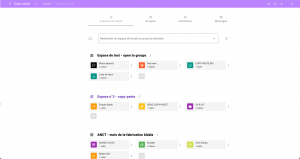

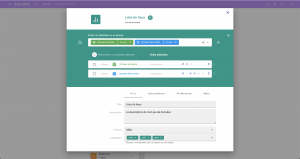

Les quelques captures d'écran suivantes donnent un aperçu de ces fonctionnalités et de leur réalisation.

Un commun générique pour des communs numériques

Le projet Data Patch revendique un statut de commun numérique à plusieurs niveaux :

- Le code source comme commun en tant que tel, ouvert intégralement, fait de l'outil lui-même un commun numérique. N'importe qui peut ainsi participer à l'amélioration du code source, selon les règles d'usage en matière de contribution sur des logiciels ouverts (sur Github ou Gitlab) : création ouverte de "tickets" ou "issues" pour relever des bugs ou proposer de nouvelles fonctionnalités, gestion collaborative de la roadmap ; système de relectures croisées des améliorations du code par l'équipe maintenant le logiciel (pull request) ; etc ...

- Les données publiées avec Data Patch en font un instrument générique permettant à des communautés de créer des communs de données. En mettant à disposition un outil libre et gratuit pour manipuler collaborativement des données. Celles-ci sont appelées à être entièrement gérées par les communautés elles-mêmes. Chaque communauté peut elle-même définir ses propres règles afin de déterminer qui a le droit de les lire, de les modifier, de proposer des modifications, comment ces données sont valorisées et visualisées...

Synergies avec d'autres projets de communs

Nous avons identifié dans le wiki d'autres projets de communs avec lesquels il serait intéressant de trouver des synergies, nommément :

- Diagnostic des mobilités

- Agora des solutions citoyennes

- Boîte à outil des circuits courts

- Démarche CodeSocial

- Espace de documentation pour les entreprises face aux risques naturels et technologiques majeurs

- Impulser des dynamiques collectives vers la résilience locale: méthodes et outils

- Infolab du territoire

- J'agis pour la biodiversité dans mon quartier

- OSCARTES

- Ressources pour la production en commun de semences paysannes

- Pas de vacance pour la vacance

Tous ces projets ont pour point commun de chercher à cartographier / recenser des initiatives sur des territoires différents et avec des communautés de contributeurs identifiées. Tous ces projets sont spécifiques dans leur périmètre territorial et les thématiques auxquelles ils cherchent à répondre, toutefois la constitution d'une base de données collaborative est pour tous ces projets une problématique transverse et récurrente et pose la question d'un outillage adapté et grand public.

Dans chacun de ces projets le porteur cherche à recueillir auprès de sa communauté des savoirs dispersés afin d'en produire une base de données structurée et largement consultable. Cette base de connaissances commune s'appuie sur la contribution de tous les membres, puis doit être mise à jour en continu au fur et à mesure que la communauté s'agrandit.

Dans chacun de ces projets on peut donc facilement imaginer qu'il y aura un besoin immédiat d'un outil adapté pour la contribution, simple, ne s'adressant pas à des spécialistes du numérique, ouvert, et qui permette la publication / valorisation de la base de donnée produite.

Ce sont précisément des cas d'usages recherchés par le projet Data Patch. Comme nous cherchons à le démontrer dans cet appel à communs il nous semble qu'un tel outil n'existe pas encore en tant que tel, et que son développement nécessite un financement propre. La complexité technique (authentification, droits, contribution, API, interfaces, interopérabilité...) et le soin à apporter à l'expérience utilisateur (design pensé pour un large public), engendrent à eux seuls des coûts importants en terme de R&D souvent rédhibitoires pour des porteurs de projets aux moyens limités.

En mutualisant la R&D et en proposant un outil libre et générique comme Data Patch on éviterait ainsi la dispersion des ressources dans chacun des projets. Cette mutualisation serait de fait une économie directe pour ces projets. Ils pourraient alors allouer plus directement leurs ressources sur leurs thématiques et leurs actions spécifiques.

...

Organisations utilisatrice ou intéressée par utiliser la ressource : Association PiNG, Co-demos, Hub CONUMM, Jailbreak, RhinOcc

Contributeurs : Gregoireb, Jpy, Mevenping, johan

Défi auquel répond la ressource : 1- Connaissances - Ressources, 3- Gouvernance

Autre commun proche : Agora des solutions citoyennes, Diagnostic Mobilité, Démarche CodeSocial, Espace de documentation pour les entreprises face aux risques naturels et technologiques majeurs, Impulser des dynamiques collectives vers la résilience locale: méthodes et outils, Infolab du territoire, J'agis pour la biodiversité dans mon quartier, OSCARTES, Pas de vacance pour la vacance, Ressources pour la production en commun de semences paysannes, Boîte à outils des circuits courts

Richesse recherchée : Cas d'usages, Financement, Expérimentation, Contributeur - Communauté

Compétences recherchée : Général/Approches, Général/Enjeux, Facteurs de résilience/Gouvernance, Facteurs de résilience/Infrastructure, Facteurs de résilience/Instruments

Communauté d'intérêt : PDVPLV

Type de licence ? Creative Commons, GNU Affero General Public License

Niveau de développement : Preuve Concept & 1er client

Cloud / Fichiers : https://github.com/co-demos/fastapi-boilerplate, https://github.com/co-demos/datapatch-front

Indiquer la localisation pour voir la carte

Tags : Base de données, Contribution, Modération

Catégories : Logiciel, Données, Connaissance

Thème : Général/Enjeux, Facteurs de résilience/Gouvernance, Facteurs de résilience/Infrastructure

Candidat Appel à Communs :

Référent ADEME :

Référent du commun : Jpy

Les 5 parties ci dessous sont à remplir obligatoirement pour analyser le commun et vous conseiller

Candidat Appel à Communs : candidat 18 Juin

Montant Aide souhaitée (en Euro) à l'Appel à Communs Sobriété et Résilience : 63700

1.Détails du Financement :

Financement

Plan de financement, chronogramme

Le financement demandé a pour objectif de permettre la réalisation du MVP (Minimal Viable Product) de Data Patch. Ce MVP a pour objectif d'être générique, de cibler un besoin récurrent mais bien identifié, et de prouver son utilité directe auprès d'utilisateurs identifiés sur le territoire autour d'une problématique commune. Ce format de projet à la fois ambitieux et circonscrit nous semble poser des bases d'une coordination simplifiée, d'une allocation des financements transparente et claire, et d'une mesurabilité des progrès réalisés. Ces éléments nous paraissent en soi être nécessaires pour garantir une meilleure conduite de projet et des résultats concrets.

Data Patch est un projet déjà en cours de développement et un prototype est d'ores et déjà en cours de réalisation. Les codes source des backend et frontend en cours de développement sont ouverts. La phase de conception s'est étendue entre mars et avril 2021. Actuellement Data Patch est en phase de développements depuis fin avril 2021. Toutes ces phases ont jusqu'ici été réalisées bénévolement.

Le montant de l'aide demandé auprès de l'ADEME correspond à 66,4 % du budget global du projet. Le budget global se répartit en plusieurs catégories de postes de dépenses :

- Gestion de projet : 9.5% ;

- Développements - contribution/modération : 58.4% ;

- Design : 13.1% ;

- Développements - cartographie : 2.9% ;

- Documentation / tutoriels : 8.0% ;

- Développements - admin sys : 8.0%.

Le plan de financement, le rétroplanning sur 6 mois, ainsi qu'une visualisation récapitulative sont détaillés dans les documents téléchargeables via les liens suivants :

Justification de l'éligibilité

- Le Commun vise bien des défis identifiés : "Connaissances - ressources", "Mieux décider ensemble" ;

- Le porteur a un statut juridique lui permettant de recevoir des aides publiques : le porteur est une entreprise, son taux actuel d'aide est compatible avec la demande d'aide ;

- Les fiches Acteurs des structures impliquées sont renseignées sur le Wiki ;

- La fiche commun est renseignée sur les 4 blocs (financement, résilience & territoire, impacts environnementaux et Synthèse) et l'auto-diagnostic ;

- Les choix liés à la licence et au modèle de développement du commun sont explicités et justifiés

La licence Affero GPL ou MIT pour le code source ; pour les données les licences sont celles de choisies par les utilisateurs avec un large choix de licences libres pour les bases de données ; pour les livrables la licence est CC 3.0 BY FR.

Le projet de commun produira des livrables sur une durée courte (6 mois).

Financement post Appel à communs

Le modèle économique post Appel à commun reposera sur la valorisation de l'accompagnement et sur le soutien aux utilisateurs : aide à la structuration des données, méthodologie, sensibilisation à l'open data, ... Pour rester cohérent avec la philosophie d'un projet de logiciel libre et accessible Data Patch n'a pas vocation à fonctionner, ni avec un système d'abonnement ou de tarification au flux, ni en valorisant les données hébergées (jeux de données ou données personnelles) avec la publicité. Il est vital que son financement et son modèle économique soient indépendants de toute injonction uniquement commerciale ou publicitaire.

Les partenaires du projet recherchent des financements complémentaires auprès de collectivités ou d'organismes nationaux (ANCT). Le modèle de développement du commun est pour l'instant de le compléter et le maintenir au fil des opportunités de financement sur projet (contrat privé ou marché public), sur appel à communs (aides publiques), ou plus simplement en valorisant l'accompagnement de porteurs de projets de communs numériques.

Il enfin est envisagé de faire appel au financement participatif (ou crowfunding). Note : Le lien indiqué ici revoit vers une page Tipee en préparation et sur laquelle n'a pas encore été engagé de communication.

Pensées comme complémentaires de la co-production par le bénévolat et des acteurs publics, les campagnes de crowdfunding permettront à la fois de diversifier les sources de financement, d'élargir la communication autour du projet, et de développer le nombre d'utilisateurs et de contributeurs.

Justification du mode de financement

Lors d'un produit numérique mutualisable - qui plus est un logiciel libre - les coûts de développement initiaux sont incompressibles (création du MVP). Pour tester et adopter un outil il faut déjà que l'outil existe dans une version minimale. Un logiciel libre visant à proposer une facilité d'utilisation proche de services tels que GSheet ou Airtable ne peut être développé et amélioré qu'en faisant appel à des compétences spécifiques. Dans l'absolu ce projet demanderait d'être développé à temps plein, seul ou en équipe. Idéalement Data Patch nécessiterait a minima 3 ou 4 temps pleins, et cela sur plusieurs années : un.e développeu.r.se full-stack / frontend, un.e devops / data engineer, un.e designer UI/UX, voire un business developer... Dans l'industrie cela représenterait aujourd'hui des salaires variant entre 3000 €/mois net à 5000 €/mois net. Un projet de logiciel libre, accessible, pour des publics peu dotés financièrement, cela n'a pas le profil pour attirer pas les investisseurs privés en masse. De fait les développements déjà réalisés sur Data Patch l'ont été grâce au bénévolat. Mais une telle situation de bénévolat n'est pas tenable sur la durée pour un projet alliant technicité et usage grand public.

Un exemple afin de prendre la mesure des investissements initiaux pour développer un commun numérique grand public : le contrat initial pour la mise en service du logiciel de participation citoyenne Decidim par la Mairie de Barcelone est estimé à 391 000 €. Notre approche est différente car incrémentale, itérative, et nous croyons qu'il est possible de parvenir à des résultats tangibles avec des investissements initiaux moindres. Néanmoins cela permet de poser un référentiel et de soutenir notre affirmation que le développement d'un logiciel versatile comme Data Patch est une ambition en soi. Créer un logiciel libre d'intérêt général - un commun générique pour des communs numériques - n'est possible que s'il est conçu et porté comme un projet à part entière.

Vu l'investissement initial le soutien de la puissance publique est un levier important pour consolider ce type de projet. Le financement via des subventions publiques est certes un aspect qu'il s'agit de soigneusement étudier pour assurer l'indépendance du projet. Néanmoins - en dehors du présent appel à communs - la question de la dépendance aux subventions et au pouvoir politique ne se pose que très rarement lorsqu'il s'agit de développer un outil libre d'intérêt général à la fois générique, ouvert, et "from scratch". L'administration finance effectivement des logiciels libres, mais en général dans deux cas assez spécifiques :

- soit il s'agit d'un besoin très circonscrit d'une administration ou d'un service, réduisant alors le champ d'usage à un public très restreint et souvent spécialiste. Cités comme des réussites les solutions issues de l'éco-sytème betagouv / datagouv sont pourtant de cet ordre. Les plateformes créées et gérées par des services centraux (Premier Ministre, ministères) peuvent accentuer un mouvement de centralisation des données, parfois de mise en silo, du fait de leur spécialisation sectorielle ou des publics utilisateurs. De plus la complexité technique des systèmes historiquement mis en place freine grandement la réutilisation des logiciels par d'autres acteurs moins aguerris techniquement ;

- soit il s'agit de la réutilisation d'une solution libre déjà existante portée par une structure privée, privant ainsi la puissance publique de sa capacité à développer en propre des projets ou produits numériques d'intérêt général.

Nonobstant ces deux cas l'Etat reste encore le mieux loti en termes de moyens pour se doter ou développer des outils numériques innovants en comparaison avec d'autres acteurs publics. Au niveau régional ou départemental, penser et financer le développement "from scratch" de solutions numériques libres reste l'exception ou le privilège d'agglomérations importantes comme à Lyon ou Paris. Pour le reste des territoires ou de la société civile (associations, fondations, entreprises, citoyens) ne subsiste que l'offre des acteurs privés en capacité de mobiliser des capitaux à la mesure des défis techniques que supposent ces services : Open Data Soft ; Microsoft ; Google, etc...

Les coûts de ces services propriétaires sont très variables mais il peut se révéler compliqué d'en estimer le poids réel. Un service "gratuit" comme Google Sheet se paie par un hébergement de données sur des serveurs appartenant à Google puis par la récupération des données personnelles par cette société ; des services par abonnement comme Open Data Soft ou Airtable se paient soit par une sur-facturation dépendant de l'usage plus ou moins intense de l'outil (facturation à l'usage de l'API, tarification au flux de données) ou encore par la limitation de certaines fonctionnalités majeures (limitation du nombre de personnes dans un groupes par exemple)...

Bref, que ce soit par manque d'outils répondant à un besoin particulier, de compétences internalisées, d'une forte centralisation, ou encore du peu de financements dédiés, au final l'offre en solutions libres et immédiatement utilisables par des acteurs locaux se révèle plutôt maigre ou compliquée à mettre en place (voir §"Impact du commun sur la résilience" dans la partie 2). Les acteurs publics territoriaux qui ont pourtant l'obligation d'être conformité avec la loi sur l'ouverture des données se trouvent alors dans une situation délicate pour s'outiller. Ils se rendent dépendants de plateformes tierces et de leurs fonctionnalités quand celles-ci existent, ou ne peuvent tout simplement pas se le permettre financièrement.

Afin de mettre en place les outils numériques essentiels d'une réelle infrastructure numérique démocratique, décentralisée, citoyenne les opportunités sont donc rares alors que les besoins sont exigeants : faire que chacun puisse partager des données sur des outils libres, les améliorer, le tout de façon décentralisée mais inter-opérable... Pour amorcer la réalisation de telles infrastructures l'appui de la puissance publique nous apparaît autant essentiel qu'au coeur de sa mission de service public.

...

2.Détails Sobriété et/ou Résilience des Territoire :

Contenu sur la résilience territoriale

Comme nous y reviendrons nous estimons que la capacité de résilience des territoires tient à leur capacité à produire, échanger, et valoriser des informations, bref à faire circuler le savoir propre à une géographie. Aujourd'hui une grande partie de l'information et du savoir est numérisée ou peut potentiellement l'être. Ajoutons qu'une grande partie de ce savoir est aussi détenue par les citoyens ou des acteurs privés comme les associations maillant le territoire (1,5 millions d'associations en France).

Pour faire face aux nombreuses crises passées, actuelles ou à venir (qu'elles soient climatiques, sociales, ou sanitaires), les acteurs publics locaux, nationaux, les associations, entreprises et citoyens doivent pouvoir se coordonner et échanger des informations. Bien que la production d'information soit historiquement très centralisée en France (administration d'Etat, organes de presse...) il est devenu évident qu'il existe un besoin de mieux faire circuler l'information et mettre en avant les actions des acteurs locaux, surtout en période de crise. Les acteurs locaux sont "en première ligne", et donc les premiers à nécessiter de recevoir ou émettre des informations.

La situation est d'autant plus critique que dans un même mouvement l'information est devenue pléthorique, que les crises se montrent de plus en plus brusques et soudaines - notamment en ce qui concerne la crise sanitaire mais bientôt aussi la crise climatique, et que les actions à mener en réponse doivent se concrétiser rapidement sur le terrain.

Penser la résilience territoriale dans ce contexte implique de repenser les infrastructures informationnelles, et en ce qui nous concerne des infrastructures logicielles de données. Qu'elles soient publiques ou privées ces infrastructures sont aujourd'hui globalement des plateformes (SaaS pour Software as a Service), centralisatrices (Etat ou GAFAM), et leur maîtrise technique ainsi que leur gouvernance échappent largement au citoyen et aux associations. Cette situation de dépendance verticale et/ou de dépendance technologique engendre une invisibilisation des acteurs territoriaux. Cette invisibilisation représente un risque majeur en situation de crise quand c'est au niveau local que s'organisent les réponses aux crises.

Nous pensons que le contexte actuel impose de manière urgente la création et la mise à disposition d'outils numériques libres pour les acteurs essentiels de l'action locale que sont les citoyens et les associations, mais aussi les petites et moyennes collectivités. Ces outils de résilience numérique doivent permettre de : échanger des informations ; co-construire des bases de connaissances communes ; les diffuser et les valoriser à toutes les échelles géographiques ; de décentraliser l'hébergement du savoir ; et enfin d'avoir la maîtrise de ces outils numériques.

Lien et ancrage territorial

Les premiers partenaires du projet - les hubs numériques Occitanie, Pays de la Loire et Bourgogne France Comté - sont responsables du recensement des lieux d'inclusion numérique au niveau régional. Leur travail de recensement s'appuie sur leur connaissance fine de ces lieux et leur ancrage historique justifiant leur statut de référent local sur cette thématique. Chaque hub est au contact de plusieurs centaines de lieux comme on peut le voir sur leurs cartographies respectives :

- Carto Rhinocc - hub numérique Occitanie ;

- Carto PiNG - tête de réseau tiers-lieux en Pays de la Loire ;

- Carto Ternum - hub numérique Bourgogne Franche Comté ;

- Carto CONUMM - hub France Connectée ;

Sans les recensements des hubs, le travail de ces acteurs / lieux d'inclusion numérique serait peu visible auprès d'instances telles que la région ou les ministères, mais également auprès des publics locaux visés (agents en charge de rediriger des citoyens vers les structures locales adaptées).

Les 'hubs numériques régionaux' ont 4 missions :

- Recenser, articuler et coordonner les acteurs de la médiation numérique pour faire converger les projets vers des priorités territoriales définies avec les collectivités ;

- Lever des fonds et aider à mobiliser toute sources de financement (notamment européennes) en montant des projets à plus grande échelle ;

- Mutualiser et apporter de la valeur aux acteurs de terrain en créant des centres de services partagés (mutualisation de parcours de formations pour les aidants, partage d’outils et de ressources humaines…) ;

- Évaluer l’efficacité des services rendus sur le territoire et en informer les collectivités et les instances de pilotage au niveau national.

La valeur et la qualité de ces recensements sont des conditions primordiales à ces missions. Elle dépendent de la relation entre un "hub régional" et sa communauté d'acteurs locaux : un hub doit être historiquement légitime pour être considéré comme un référent central pour tous les acteurs, et les acteurs eux-mêmes doivent posséder une connaissance fine de leur lieu. Ensemble ils co-construisent des bases de connaissance, le hub jouant un rôle essentiel de coordination et de diffusion.

La communauté d'utilisateurs actuelle du projet Data Patch se décompose comme suit :

- Les 4 hubs régionaux membres du groupement : Occitanie ; Pays de la Loire ; Bourgogne Franche Comté. Chaque hub possède lui-même une communauté d'acteurs et de lieux de taille variable.

- Chaque hub alloue en général 2 à 3 personnels en interne, responsables du recensement.

- En tout ces 4 hubs ont recensé environ 1800 lieux / acteurs.

La communauté des hubs numériques est une communauté qui ne se résume pas à ces seuls 4 hubs. En tout ce seront à terme 11 hubs qui couvriront le périmètre de cette mission pour un numérique inclusif pour le territoire français. La communauté d'utilisateurs initiale est donc appelée à grandir. Conséquemment les bases de données que ces hubs partageront entre eux ou avec l'administration centrale seront elles aussi appelées à s'étoffer. Il apparaît certain que le besoin de rendre ces données interopérables et compréhensibles ne fera que devenir plus pressant, tout comme le besoin de faciliter leur mise à jour par les communautés locales.

Description de la communauté Territoire

Les territoires à partir desquels nous travaillons sont ceux de ces hubs numériques : Occitanie, Pays de la Loire, Bourgogne Franche Comté. Les communautés avec lesquelles nous à travaillons seront donc celles des hubs numériques partenaires, c'est-à-dire les communautés de lieux d'inclusion numérique. Ces communautés représentent environ 1800 lieux et donc d'acteurs actuellement, comme on peut le vérifier sur les cartographies mises en lien plus haut. Ces lieux et ces acteurs possèdent des profils très variés, allant du bureau de poste au fablab, sans oublier les tiers-lieux de toutes sortes. Cette variété de profils nous incline vers une définition de nos publics comme étant le "grand public", qu'il faut considérer par défaut comme non spécialiste.

En développant sur un temps relativement court (6 mois) et des cycles courts de développement (voir le chronogramme plus haut), nous chercherons à vérifier et à mesurer avec ces groupes nos différentes hypothèses de travail, à ajuster nos objectifs, et à intégrer ces retours dans la feuille de route du projet (fonctionnalités, accompagnement, etc...). Les questions principales que nous nous poserons pour évaluer notre impact sont les suivantes :

- L'outil est-il facile à prendre en main par les producteurs de données ?

- L'outil est-il facile à prendre en main par les contributeurs / la communauté des producteurs ?

- L'outil peut-il être facilement être installé en propre par les services techniques du producteur de données ? Ce besoin d'indépendance technique est-il exprimé ?

- L'outil permet-il de valoriser correctement les données mises en commun (tableurs partagés, cartographie interactives, formulaires...) ?

- Une relation se tisse-t-elle correctement entre un producteur de données et sa communauté (email, message, notifications...) ?

Justification du/des défis choisis

- Défi "Ressources - connaissances" : le projet Data Patch vise à la fois à contribuer à créer des nouvelles connaissances numériques mises en communs (des jeux de données ouverts, collaboratifs et contributifs ), et à proposer une ressource / outil numérique ouvert précis, libre, permettant cette création de bases de données collaboratives.

- Défi "Mieux décider ensemble" : par son principe de contribution ouverte sur les données et ses fonctionnalités d'échanges directs entre producteurs de données et citoyens contributeurs (messages, mails), le projet Data Patch cherche à améliorer la qualité de jeux de données en open data. Citoyens, associations, entreprises, élus, sont tour à tour producteurs et utilisateurs de données. Ainsi le projet se veut être un moyen d'instaurer un lien plus direct et de confiance entre producteurs de données et citoyens, entre société civile et puissance publique, en simplifiant la production/diffusion/circulation de nouvelles informations sur le territoire.

Impact du commun sur la résilience

Nous avons précédemment évoqué comment la capacité de la résilience des territoires tenait entre autres à leur capacité à produire, échanger, et valoriser des informations relatives à une géographie ou une thématique particulière. Cette capacité est déterminée à la fois par les compétences techniques des individus ou des équipes, par les moyens financiers des structures, par la relation de confiance entre citoyens et représentants de la puissance publique, mais aussi par les outils à leur disposition.

A court terme notre commun vise à avoir un impact direct sur la résilience des territoires de nos partenaires en améliorant l'information sur les lieux d'inclusion numérique et les tiers-lieux. La qualité de cette information est primordiale pour assurer une meilleure coordination entre citoyens, pouvoirs publics, et réseaux d'acteurs. Et là encore la qualité de l'information dépend de la capacité des têtes de réseaux à inclure les acteurs locaux dans la production de ces données.

Nous posons ici un double constat : 1/ les personnes en charge de l'information territoriale (open data) ou leurs publics ne sont pas tous des ingénieurs informatiques ; 2/ les outils libres à disposition aujourd'hui ne permettent pas de remplir cette mission à moindre frais, ou le font de manière trop sectorielle (en "silo"). Pour améliorer la capacité de résilience des territoires en matière d'information il faut donc produire des outils libres, accessibles, et conçus pour un public le plus large possible.

Les services techniques des collectivités ou les structures para-publiques qui produisent des données d'intérêt public utilisent au quotidien majoritairement des outils de type tableur, en ligne (GSheet, Airtable, ...) ou installés sur leur ordinateur (Excel, Open Office). Malheureusement ces outils ne répondraient qu'à une partie de toutes les contraintes d'une approche open data complète :

- produire des jeux de données : en saisie directe ou en important des fichiers locaux ou distants ;

- mettre à jour et améliorer des jeux de données de manière collaborative ou non : corriger des inexactitudes ; ajouter ou supprimer des entrées ; ajouter ou supprimer des colonnes, ... ;

- publier des données : les rendre accessibles à des services tiers ; les exporter sous divers formats, les re-publier sur d'autres plateformes ... ;

- valoriser des jeux de données : cartographie ; listes ; filtres ; exports... ;

Les services de gestion de base de données en ligne sont par ailleurs pour l'ensemble des outils propriétaires. Leur code source est fermé, leurs serveurs sont invisibilisés (le "cloud"), et leurs coûts peuvent se révéler prohibitifs à long terme. Les coûts d'abonnement sont parfois calculés en fonction du nombre de requêtes (Open Data Soft), du nombre de collaborateurs au sein d'un groupe ou en fonction du nombre de jeux de données mis en ligne (Airtable)... Des coûts qui paraissaient modiques au départ peuvent alors augmenter exponentiellement au fur et à mesure que s'additionnent jeux de données et nouveaux utilisateurs.

Nous sommes bien conscients que quelques exceptions existent comme BaseRow, NocoDB ou FramaCalc, des logiciels libres faisant peu ou prou de la gestion générique de bases de données. Ces solutions donnent l'impression à premier abord qu'elles pourraient répondre aux besoins que nous avons relevés. Pourtant, lorsqu'on commence à les implémenter pour les cas d'usages qui nous intéressent (celui des hubs numériques notamment) des blocages apparaissent rapidement ou se révèlent très coûteux à résoudre. Prenons par exemple NocoDB, pour lequel il faudrait implémenter le multilingue car entièrement l'outil est entièrement en anglais. De manière moins anecdotique le problème de ces solutions libres est que ce sont des outils techniques complexes (à modifier, à utiliser ou à installer), et qu'il faudrait surtout refondre une grande partie de leur code source pour arriver à implémenter deux choses essentielles : d'un côté le système de contribution ouverte couplé à un système de modération ; de l'autre un design de frontend simple, intuitif, qui soit manipulable par des publics non spécialistes. C'est bien pour ces raisons que même de grandes administrations publiques ou des acteurs historiques de l'open data continuent à utiliser des outils propriétaires fermés comme GSheet ou Airtable, faute d'alternative probante et adaptée telle que celle que nous portons.

Une réelle résilience des acteurs des territoires en termes de systèmes d'information et de bases de données implique que les acteurs territoriaux puissent avoir une maîtrise complète de leurs outils : a maxima d'avoir les compétences pour modifier les codes sources et l'hébergement des bases de données ; ou a minima que ces outils soient bon marché, simples, et qu'on puisse avoir voix au chapitre quand il s'agit de la gouvernance de ces outils (la manière dont ils sont développés, leur coût, les fonctionnalités à ajouter, etc...).

Le projet Data Patch se propose comme une réponse à ce problème en garantissant à fois la transparence d'un projet open source et une architecture décentralisée. Ajoutons qu'une des fonctionnalités nodales de l'outil est la contribution ouverte et leur modération. Au-delà de compléter l'offre libre avec un nouvel outil grand public de gestion de base de données, nous proposons une manière alternative de consolider des liens avec une communauté autour de thématiques particulières. Le système "contribution ouverte / modération" nous apparaît central pour à la fois permettre d'améliorer des données de manière non invasive, et d'installer une relation de confiance entre les usagers/citoyens et les producteurs de données.

...

3.Détails Impacts environnementaux :

Impact environnementaux

Estimation des Impacts et Gains Environnementaux à court et moyen termes

Le projet Data Patch à pour première externalité positive de permettre aux porteurs de projet de mieux cibler leur ressources humaines et financières sur leur action spécifique, et non dans des développements numériques / techniques sortant de leur premier champ de compétences. D'expérience nous pouvons affirmer que les coûts directs ou induits de développements sont très souvent sous-estimés ou mal anticipés par les porteurs de projets, ce qui génère par la suite des surcoûts (maintenance, améliorations, design) au détriment de la bonne menée des projets eux-mêmes.

Prouver les gains environnementaux directs ou à court terme de l'usage de Data Patch (ou plus largement de toute solution numérique) est un défi qu'il nous reste à relever. On peut néanmoins poser comme hypothèse que l'outil peut avoir un réel impact indirect, du moins quand il est utilisé dans le cadre de projets à caractère environnemental tels qu'on en trouve dans cet appel à communs.

Data Patch propose en effet un moyen pour faciliter la constitution de bases de connaissances ouvertes et améliorables par des communautés. En permettant une meilleure allocation des ressources de ces porteurs de projets et une économie substantielle dans leur mise en place d'infrastructures de données, Data Patch aura donc plutôt pour effet de catalyser l'action des porteurs de projets, qu'il s'agisse de mobiliser ou sensibiliser autour de thématiques environnementales au sens large, de les cartographier, de les planifier, ou de les documenter.

Publication de certaines données environnementales en open data

Le logiciel Data Patch a pour principale fonctionnalité de faciliter la publication en open data de tout type de jeu de données. La licence choisie lors de l'ouverture des jeux de données est de la responsabilité des producteurs/responsables des jeux de données. Les licences proposées par l'application Data Patch font toutefois la part belle aux licences libres en en proposant un large choix.

Lien avec la communauté Open Data

Les porteurs et les participants du projet sont proches des acteurs de l'open data en France. Le lien serait à renforcer surtout avec les communautés Open Data France, Datactivist, APRIL, ADULLACT, AFUL, la MedNum ainsi qu'avec les associations et collectivités locales sensibles aux problématiques de l'open data et du logiciel libre (comme Réseau Français des Fablabs, la région Occitanie, ou le département de Loire-Atlantique par exemple).

...

4.Synthèse du projet de Commun :

Synthèse

Expérience du porteur de Commun dans le domaine

- Julien Paris - Collectif Co-demos : après une formation initiale d'architecte DPLG puis dans la recherche (doctorant CNRS en Turquie) je me suis reconverti dans le numérique en tant que développeur fullstack. Je développe uniquement des logiciels ouverts et je milite ainsi de cette manière pour soutenir le mouvement de l'open data et du logiciel libre. Ces dernières années j'ai principalement travaillé pour des institutions ministérielles (Bercy, CGET, Agence Bio), inter-ministérielles (DINUM), des associations et think tanks acteurs de l'intérêt général (PiNG, Ternum, Rhinocc, Décider Ensemble), ainsi que des structures publiques comme une bibliothèque près de Nantes. J'ai aussi participé au programme "Entrepreneur d'Intérêt Général" d'Etalab en 2018. J'ai produit des outils numériques libres permettant la publication et la visualisation de données : Apiviz, baromètre des résultats des politiques publiques, tableau de bord des aides aux entreprises, Solidata, Synapse, LibViz...

Un résumé des références est consultable ici : Fichier:Références.pdf.pdf

Informations liées au Commun et au problème identifié

Le projet répond à 2 objectifs principaux, chacun faisant écho à un défi :

- Défi 1-Connaissances - Ressources // Objectif : Proposer un outil libre et une plateforme ouverte facilitant la production de communs numériques (bases de données ouvertes) : c'est-à-dire simple à prendre en main par les producteurs de données ou les citoyens, techniquement stable, peu chronophage pour les producteurs de données ;

- Défi 3-Mieux décider ensemble // Objectif : Consolider des communauté thématiques autour de ces communs numériques.

Description des actions, livrables et planning associé en proposant des points de passage (communauté/commun à tel niveau d'ici 3, 6, 9, 12 mois)

Comme vous pourrez l'observer dans le chronogramme téléchargeable plus haut, le chantier budgété dans le cadre de cet appel à communs est planifié sur 6 mois. Ceci ne nous empêche pas d'anticiper des actions au-delà de cette période (indiquées ci-après comme "hors périmètre chiffré").

La raison de ce phasage à 6 mois est la suivante. Dans le cas d'un projet d'innovation numérique une étape essentielle est de réaliser la preuve de concept fonctionnelle et stable de l'outil développé, encore appelée "MVP" (Minimum Viable Product). Au terme de cette phase il doit être vérifié que l'outil fonctionne techniquement, que sa conception et son architecture permettent d'en faire un véritable logiciel libre (simple à installer / instancier), et que la communauté des premiers utilisateurs peut apporter des retours en continu lors de cycles courts de développement.

Ce n'est qu'au terme de cette phase primordiale qu'est la validation du MVP en étroite relation avec les premiers utilisateurs (en l'occurrence les hubs numériques) que des actions ultérieures pourront être possibles. Après la réalisation du MVP il sera pertinent de penser à de nouvelles actions et de leur trouver des modes de financement propres.

À 3 mois - dans le périmètre chiffré

- Code source intégralement ouvert (déjà en place) ;

- Développement et mise en production de la version beta de l'outil, comprenant les fonctionnalités de base : import, export, édition, authentification, gestion des droits, module de contribution

- Tests utilisateurs auprès de la communauté des hubs numériques ;

À 6 mois - dans le périmètre chiffré

- Intégration des retours utilisateurs issus de la première phase ;

- Documentation d'installation et tutoriels d'utilisation ;

- Amélioration des fonctionnalités de collaboration en temps réel ;

- Interopérabilité avec des solutions existantes de data-visualisation et de valorisation de données : Open Street Map, Apiviz....

- Dockerisation des codes sources pour une instanciation / réutilisation simplifiée ;

À 9 mois - hors périmètre chiffré (après réalisation du MVP)

- Ajout de modules de visualisation : fiches, tableur, kanban, calendrier .... ;

- Développement des fonctionnalités permettant une décentralisation et une industrialisation de la solution : Activity pub ;

- Cycles/sprints d'amélioration continue ;

- Elargissement du premier cercle d'utilisateurs à des

À 12 mois - hors périmètre chiffré (après réalisation du MVP)

- Industrialisation de la solution : appel à intérêt auprès de structures régionales et départementales en France métropolitaine et DOM/TOM, étude de cas d'usage à l'international (Espagne, Angleterre, Italie).

Taille de la communauté de contributeurs et d'utilisateurs impliquée

Notre communauté d'utilisateurs actuelle se décompose comme suit :

- Les 4 hubs régionaux membres du groupement : Occitanie ; Pays de la Loire ; Bourgogne Franche Comté. Chaque hub possède lui-même une communauté d'acteurs et de lieux de taille variable.

- Chaque hub alloue en général 2 à 3 personnels en interne, responsables du recensement.

- En tout les 4 hubs ont recensé environ 1800 lieux / acteurs.

La communauté des hubs numériques est une communauté qui ne se résume pas à ces seuls 4 hubs. D'autres référents régionaux seront désignés ces prochains mois ou années afin de couvrir tout le territoire français, métropolitain et outre-mer.

Estimation du Rapport Coût / Impact du Commun dans le domaine de la résilience

L'évaluation de l'impact direct de notre commun numérique sur la résilience d'un territoire ne pourra se mesurer qu'à moyen terme. Dans l'immédiat il est d'abord certain qu'une plateforme ou un outil de gestion de bases de données est un besoin partagé par tous nos partenaires territoriaux. Son absence génère à la fois des complications internes au sein des structures, ralentissant leur mission et la mise en place de référentiels nationaux. L'absence de système simple permettant la contribution des communautés aux bases de données a aussi des conséquences sur la qualité des données recensées. Créer et mettre à disposition Data Patch aurait pour effet immédiat sur la résilience d'améliorer le travail d'information territoriale mené par les têtes de réseaux et d'améliorer la qualité des données publiées et partagées.

La réflexion sur les indicateurs à créer pour mener une évaluation précise de l'impact de notre commun sur la résilience est encore ouverte : économies financières réalisées par les structures ? économies en terme de temps ? montée en compétences ? nombre de contributions communautaires sur un jeu de données ? ...

On peut par exemple estimer qu'en mutualisant le développement et la mise en place de Data Patch pour différents projets locaux (ceux de nos partenaires pour débuter) on pourrait commencer à prendre la mesure des économies d'échelles réalisées. Si par exemple l'outil était utilisé ne serait-ce que par une petite portion des projets que nous avons listés (dans la description, §"Synergies avec d'autres projets de communs") il serait possible de déterminer l'économie réalisée sur les dépenses de développement.

On peut aussi imaginer un scénario inverse, où chacun de ces projets mettrait en place des outils différents de gestion de base de données, ad hoc, non génériques, même libres, par de prestataires différents... Le coût d'un tel investissement peut facilement se chiffrer en milliers voire dizaines de milliers d'euros (que ce soit en développement ou en conseil) pour chaque projet. C'est à cause du poids financier qu'augure un tel chantier - et non l'absence de besoin - qu'à l'heure actuelle aucun de nos partenaires n'a individuellement mis en place de système ouvert de contribution communautaire.

La raison d'être du projet est bien de mutualiser la R&D d'un besoin générique et récurrent, dans tous les projets où un producteur de données (type hub numérique régional, association) est appelé à co-construire une base de connaissances avec une communauté plus diffuse. L'amortissement que permettrait la mutualisation et la mise à disposition d'un tel système d'information est conséquent. Il limiterait le risque à la fois de "saupoudrage" de l'argent public et d'obsolescence de solutions numériques similaires mais réalisées ponctuellement pour chaque projet.

Le projet Data Patch présente l'avantage de ne pas être spécifique à un territoire. II intègre dès sa conception la possibilité de pouvoir être mobilisable par des projets très différents sur le fond, mais qui ont tous ce même besoin de constituer des bases de connaissances communes. C'est en ce sens que nous concevons Data Patch comme une infrastructure légère et décentralisée, aussi utile qu'un postier ou une cabine téléphonique (pour ceux qui s'en souviennent) en cas de crise.

Le logiciel est entièrement open source, il s'appuie sur des communautés open source (librairies Python, framework Javascript très utilisées et pérennes) et s'ouvrira rapidement à celles de l'open data (Open Data France, Datactivist), permettant la reprise du code par une large communauté de développeurs et d'investir les financements dans le développement de l'outil tout en en faisant bénéficier toutes les communautés porteuses de projets territoriaux.

Commun et intérêt général

- Améliore la coordination entre acteurs hétérogènes (public, privé, formel, informel, petit, grand…)

Le projet Data Patch cherche à simplifier cette coordination en cherchant à répondre à trois choses simultanément :

1/ proposer un outil technique complexe...: pouvoir créer des jeux de données ouverts, permettre de collaborer sur des jeux de données, gérer les droits en écriture/lecture/modification, générer des API dynamiquement, permettre la création ou la connexion à des modules complémentaires indépendants (dataviz)...

2/ ...mais simple à utiliser... : le soin apporté au design et à l'expérience des utilisateurs sont tout également importants que les performances purement technique. Pour que la création de bases de connaissances ouvertes se démocratise, les interfaces doivent être pensées pour s'adresser à tous : formulaires, tableurs, data-visualisation, gestion des droits... Ce travail de design nous semble essentiel pour être certain que des profils de personne

3/ ...et bon marché : notre proposition a pour contrainte forte de chercher l'adoption de nos outils par des acteurs aux moyens financiers et aux ressources humaines très limités. Notre réflexion sur les modes de financements repose sur un mix où les premiers développements incompressibles reposent sur une partie de bénévolat ainsi que sur la commande ou la subvention publique, et où ensuite se mêlent crowfunding, valorisation de l'accompagnement, et réponses à projets. Ce mix nous permet alors de proposer une offre gratuite en SaaS, et un logiciel libre bien documenté permettant son installation de manière totalement indépendante.

- Parvient à produire des effets là où le marché seul n’y parvient pas

Le marché actuel et l'offre de services de gestion de bases de données en ligne ne sont pas adaptés à des acteurs de taille modeste ou avec des moyens humains ou financiers limités. Les acteurs tels que les associations, les petites collectivités, voire parfois des agglomérations ou des services techniques de l'administration centrale sont de cet ordre. L'offre de marché actuelle s'adresse malheureusement : et/ou à des acteurs en capacité de déployer des solutions techniques complexes ou de développer des solutions ad hoc ; et/ou à des acteurs dotés de moyens financiers leur permettant de pouvoir supporter le coût de licences ou de tarification au flux. Se pose également la question de l'extra-territorialité du droit américain quand des données publiques sont stockées sur des services de cloud de sociétés étrangères.

Quant à l'offre en termes de logiciels libres celle-ci est relativement peu diversifiée, et les solutions existantes sont peu adaptées au grand public non spécialiste de la data (notamment francophone, cf. §"Impact du commun sur la résilience" dans la partie 2). Elles sont souvent très spécialisées et prédéterminent un usage donné (portail open data, portail de participation citoyenne), peu adaptables ou modulables, et sont pour l'ensemble compliquées à mettre en place ou à utiliser (et donc paradoxalement elles aussi assez chères à la mise en oeuvre).

Tous ces éléments aboutissent à un état de fait où les acteurs que nous cherchons à outiller ne maîtrisent pas leur système d'information ou leurs outils de gestion/publication de données... quand ils n'en ont tout simplement pas. Ces différentes barrières à l'entrée font que ces acteurs que nous considérons comme centraux dans la vie publique sont tout bonnement privés de la capacité à produire des bases de connaissances communes à l'échelle territoriale. Notre projet est de tenter de combler une partie de ce manque, et de donner cette capacité à produire de la connaissance partagée à des acteurs qui en sont actuellement privés de fait.

- Participe à la réalisation d’un objectif d’intérêt général et génère un bénéfice global pour la société

L'objectif est d'ouvrir la possibilité à tout type d'acteur - allant du citoyen à l'administration en passant par les associations - de produire des bases de connaissances communes variées, partageables, et de qualité grâce au système de contribution/modération. Le point que nous voulons souligner par le terme "tout type d'acteur" est que cette possibilité doit être tout autant technique que financière. Nos réflexions sur le modèle économique sans abonnement, sur la part donnée à l'effort de design et de documentation dans notre budget, sur la valorisation de l'accompagnement et non de l'outil, font partie intégrante de cet objectif.

Les petits acteurs jouent un rôle central dans la vie démocratique et économique. Pourtant dès qu'il s'agit d'apporter des arguments chiffrés ou des données produites de manière indépendante ces acteurs n'ont pas à disposition les outils modernes nécessaires pour parler d'égal à égal avec de grandes institutions ou de grandes structures privées. II nous semble qu'un débat démocratique n'est équilibré que si chacune des parties peut mobiliser des moyens similaires. Le bénéfice global pour la société est de permettre que la discussion citoyenne et démocratique puisse s'enrichir d'une nouvelle forme de participation active des "petits" acteurs en les outillant en matière de data.

- Lève des barrières à l’entrée pour de nouveaux acteurs

Les barrières à l'entrée que nous avons identifiées sont de plusieurs ordres : d'ordre technique (complexité), du domaine des usages (permettre un usage grand public), et d'ordre financier (coût de développements, d'abonnements, de maintenance). Ces barrières sont fortes et seule l'une d'entre elles peut se révéler excluante pour les acteurs auxquels nous nous adressons.

Nous cherchons à lever de manière cohérente toutes ces barrières simultanément, en proposant ici un projet technique ambitieux car générique, ouvert à tous car porté par la possibilité de contribuer à des données sans avoir à se créer de compte, et accessible financièrement car pensé comme un projet libre valorisant l'humain avant la technique.

- Ne génère pas des effets d’enfermement propriétaire ou lock-in

Data Patch est avant tout un projet open source. Son code source est réappropriable par qui veut ; la documentation d'installation et les tutoriels cherchent à simplifier cela. Au-delà de cela les données stockées sur Data Patch sont interopérables et requêtables via une API. Il est possible à chaque instant de récupérer les données stockées sur Data Patch, soit par un système de requête, soit en téléchargement direct de fichier (type .csv, .json...).

Par différents retours d'expérience nous savons qu'il est n'est pas acceptable par des utilisateurs que les données qu'ils stockent sur un service numérique soient immédiatement publiées en open data. Prenons comme exemple le cas où un producteur de données cherche à produire des indicateurs, agglomérant des jeux de données personnelles et des jeux de données publics. Dans ce cas les jeux de données personnelles n'ont pas vocation à être publiés en open data, par contre les données publiques et les indicateurs oui. Un choix de licences libres doit pouvoir être proposé aux utilisateurs, mais ils doivent aussi pouvoir gérer finement les droits en lecture, en écriture, en modification, des jeux de données dont ils ont la responsabilité.

Notre proposition cherche à éviter tout effet de lock-in en mettant en place toutes ces fonctionnalités : variété des licences libres associées aux jeux de données publiés, gestion des droits, API ouvertes mais sécurisées, possibilité de télécharger ses propres données à tout instant.

- Participe à la création de standard ouvert pour tous les acteurs d’un domaine

Une des composantes du projet Data Patch est celle de pouvoir éditer et partager autant les données elles-mêmes que leur schéma de données. Chaque colonne d'un tableur dans Data Patch est décrite de manière conforme au standard Frictionless data afin de pouvoir partager via l'API des métadonnées de type Data Package. Ces métadonnées permettent alors une meilleure interopérabilité, comme leur validation auprès d'un schéma de données officiel, et permettent d'être réutilisées par des producteurs de données travaillant sur des données semblables.

- Autre

La dynamique que nous cherchons à impulser par ce projet vise également à mobiliser des acteurs engagés dans la vie démocratique et dans le mouvement de l'open data, au-delà de nos partenaires immédiats (cf. 3. §"Lien avec la communauté Open Data").

Cette dynamique apportera à ces assemblées un nouvel outil, de nouveaux interlocuteurs, et des projets concrets, territorialisés, de créations de bases de connaissances partagées. Nous pensons que cela pourrait consolider des liens entre anciens et nouveaux acteurs, leur apporter des retours d'expériences précieux, ou encore donner plus de poids à des projets différents du nôtre mais tout autant mus par le souci de l'intérêt général.

...

5.Autodiagnostic :

Autodiagnostic

Le problème est-il défini ? seul ou par plusieurs personnes ?

La formalisation du diagnostic et du problème originel ont été le fruit d'une expérience et d'un travail commun entre les hubs numériques (Rhinocc, CONUMM, PiNG), et les porteurs de projet. Cette formalisation s'est traduite d'abord par une proposition de besoin sur la plateforme de consultation de l'ANCT ainsi qu'une première proposition de projet.

Le problème est bien celui de faciliter la mise à jour de ces données ouvertes et d'intérêt général. Ces données sont de fait des communs numériques, co-construits d'une part par une structure responsable de collecter, et d'autre part par une communauté plus ou moins large de contributeurs.

Le but est de résoudre ce problème sans passer par des logiciels propriétaires. Cela demande la mobilisation de savoirs techniques spécifiques, une attention au design, et une conception/ingénierie spécifique à un projet de logiciel libre. C'est à ce constat que nous - porteurs de projet et partenaires - avons collectivement abouti, après plus d'un an à travailler de concert sur des projets de recensement de lieux à l'échelle régionale, le tout avec des moyens très limités.

Généralisation du problème

Le problème plus généralement c'est que le "cloud" c'est l'ordinateur de quelqu'un d'autre. Les données personnelles ou produites par des institutions publiques ou des entreprises privées font rarement exception.

Qu'on ait besoin de cartes interactives, de listes des fiches, des filtres de sélection, bref dès qu'on a besoin d'un site vivant et agréable il faut bien stocker des données quelque part, les rendre accessibles mais aussi les protéger du piratage et être certain de leur trouver une gouvernance.

Qu'on utilise Google Sheet ou Airtable vos données (tableurs, listings, textes...) sont stockées sur des serveurs et par des sociétés (GAFAM) sur lesquelles nous - citoyens, internautes lambda, petites structures, associations, parfois administrations - n'avons que très peu voire aucun levier pour vérifier ce qu'il en est fait. A une époque où l'échange d'informations fiables est devenu un sujet critique il est semble dangereux qu'une poignée sociétés privées, souvent extra-européennes, soient de fait en situation de monopole sur les infrastructures de partage de données.

Au-delà du problème technique et monopolistique il existe un autre angle mort, celui de la contribution ouverte et de la modération. Le temps de la donnée produite d'"en haut" est en passe d'être révolu. Les citoyens et utilisateurs sont de plus en plus demandeurs de ne plus être considérés comme de simples consommateurs d'information, mais bien comme des participants, des contributeurs.

Que ce soit sur les réseaux sociaux ou les plateformes de contenus ou d'open data, la contribution ouverte bute souvent sur le problème de mise à jour ou de modération. La modération sur des plateformes / réseaux sociaux propriétaires est essentiellement réalisée ex post par la plateforme elle-même : un internaute peut y écrire ce qu'il veut, ce qu'il écrit est immédiatement publié, est visible par tous, et si - et uniquement si - le contenu est signalé ce sont alors des employés de ladite plateforme qui se chargent de supprimer le contenu...

Pour que les informations gagnent en qualité tout en restant ouverte à tous, il est nécessaire qu'elles puissent être relues par des pairs, modifiées, validées, avant d'être enfin re-publiées... Une personne seule ne suffit pas pour ce travail, il est toujours nécessaire et préférable de mobiliser une intelligence collective.

A l'heure de l'économie de l'attention on peut comprendre en quoi les GAFAM n'ont pas d'intérêt économique à améliorer la qualité de l'information grâce aux utilisateurs, chose qui causerait un "ralentissement" des flux permanents de données sur leurs plateformes. Les startups traditionnelles n'ont d'ailleurs elles non plus aucun intérêt à laisser des internautes contribuer sur une plateforme sans qu'ils y troquent des informations personnelles (email, âge, préférences, etc...). A notre sens ce n'est pas un hasard que seuls des services ouverts et libres comme Wikipédia ou Framasoft se soient emparés de ce problème.

Y a-t-il d’autres contributeurs prêts à travailler sur ce Commun ?

- Dans le cadre de nos expériences communes dans le domaine du partage de données ouvertes et de cartographie ou de data-visualisation, nous sommes au contact avec une quinzaine d'"acteurs métier" qui partagent la vision de notre projet. Ces acteurs sont aussi des promoteurs de l'open data. A ce stade ce ne sont pas des contributeurs à proprement parler, mais chacun des échanges aide à préciser le besoin au coeur de notre projet.

- Ce ne sera pas notre rôle de "porter" une communauté d'intérêt particulière. En revanche si le projet est retenu et qu'il prend de l'ampleur, nous prévoyons plutôt de porter notre effort sur les personnes de type "parties prenantes" pour : identifier de nouveaux acteurs intéressés par notre proposition ; identifier des bugs à corriger ou des fonctionnalités à ajouter ; voire à terme de créer des "collèges" d'utilisateurs. Ces personnes pourraient devenir contributeurs, peut-être prescripteurs, et initier alors une véritable communauté.

- Enfin, Data Patch faisant un usage d'autres logiciels libres pour fonctionner, les auteurs de ces logiciels contribuent indirectement à ce commun.

Préciser la compréhension du contexte, la définition considérée de la résilience et l'impact du Commun sur le défi considéré

Ces points sont détaillés dans la partie n.2 "2.Contenu Résilience et Territoire", mais on pourrait les résumer ainsi :

- Dans un contexte où les crises (climatiques, sociales, ou sanitaires) s'accentuent et s'accélèrent, le rôle des acteurs locaux (associations, collectivités, citoyens) est essentiel pour garantir des réponses concrètes, rapides et efficaces au niveau territorial. Le risque est que pour des raisons structurelles (centralisation de la décision) ou techniques (plateformisation, GAFAM) ces acteurs soient invisibles aux yeux de la puissance publique centrale.

- Notre définition de la résilience territoriale se focalise sur la capacité des territoires à mettre à disposition de tous ces acteurs locaux des infrastructures informationnelles / numériques efficaces pour créer des communs de connaissances numériques, tout en évitant les écueils de la centralisation et de la plateformisation propriétaire qui priveraient ces acteurs de la maîtrise de leurs outils numériques.

Notre projet cherche à avoir un impact double, en résonance avec les défis 1 et 3 :

- "Défi 1 - Ressources - connaissances" : contribuer à créer des nouvelles connaissances numériques mises en communs (des jeux de données ouverts, collaboratifs et contributifs ), et à proposer une ressource / outil numérique ouvert précis, libre, permettant cette création de bases de données collaboratives.

- "Défi 3 - Mieux décider ensemble" : améliorer la qualité de jeux de données publics, instaurer un lien plus direct et de confiance entre producteurs de données et citoyens, et simplifier la production/diffusion/circulation de nouvelles informations sur le territoire.

Est-ce que les contributeurs sont structurés via une association, entreprise pour recevoir des financements ?

Le porteur de projet est une entreprise.

Est ce que les besoins sont exprimables pour développer le commun ? oui/non

Oui, une première phase de formalisation commune des besoins a été réalisée afin de formuler une proposition dans le cadre de la consultation de l'ANCT :

Développer le commun suppose pour nous d'élargir la base de premiers utilisateurs à partir de celle que nous représentons actuellement, ceci lors de cycles courts de R&D. La première communauté et première utilisatrice est celle des référents régionaux Hubs Numériques ou France Connectée avec lesquels nous travaillons depuis plus d'un an :

- Rhinocc - hub numérique Occitanie ;

- PiNG - tête de réseaux des tiers-lieux en Pays de la Loire ;

- Ternum - hub numérique Bourgogne Franche Comté ;

- CONUMM - hub France Connectée ;

Cette communauté est elle-même référente pour environ 1800 lieux ou acteurs territoriaux. Notre premier objectif sera d'abord de mieux qualifier / ajuster l'outil (retours utilisateurs), puis d'élargir l'utilisation/adoption de l'outil par d'autres hubs numériques sur le territoire français - ou si le projet était retenu d'en proposer l'usage à d'autres projets retenus dans cet appel à communs ( cf. §"Synergies avec d'autres projets de communs" dans la description ).

En parallèle ou après la première phase de réalisation (MVP), il s'agira d'élargir l'adoption de l'outil par d'autres référents locaux acteurs de la transition écologique ou de l'innovation sociale. Une exploration à l'international est également envisageable. Le logiciel est en effet conçu comme multilingue depuis sa conception, et certains partenaires possèdent des homologues à l'international.

Pour développer davantage le commun, l'objectif à terme sera de constituer des collèges d'utilisateurs, parties prenantes (associations ou acteurs publics). Le rôle de ces collèges sera à la fois de faire remonter des besoins, et de participer à l'essaimage / adoption de l'outil sur de nouveaux territoires et par de nouveaux acteurs (rôle de prescription).

Quels sont les besoins à ce jour pour passer à l'étape suivante :

- conseils

- sur le sujet des communs

- conseils sur le sujet de la résilience

- mentorat

- accès à des données

- accès à des cas d’usages

- besoin d’expérimenter en situation “réelle” (usager, infrastructures)

- des contributeurs et d’autres parties prenantes

- accès à des financement

...

La réalisation du projet de commun sélectionné :

6.Réalisation du projet de commun:

Liste des CR d'atelier en lien avec ce Commun Data Patch: aucun pour le moment